Lügen, Betrug und Täuschung

„KI zum Lügen trainiert“ – Studien stützen Aussage von Tesla-CEO

Weltweit greifen Millionen Menschen für ihre Arbeit oder in der Freizeit auf Künstliche Intelligenz zurück. Doch wie zuverlässig und vertrauenswürdig ist diese Technologie? Mehrere Forscher äußern Bedenken, denn die KI spiele oft ein falsches Spiel mit ihren Benutzern.

Wenn KI die Fähigkeit zur Täuschung erlernt, können sie von böswilligen Akteuren, die absichtlich Schaden anrichten wollen, effektiver eingesetzt werden.

Foto: FotografieLink/iStock

Hingehen und mit einem Menschen reden, oder nicht? Diese Frage stellen sich viele Menschen mit Selbstzweifeln, wenn sie in einer Alltagssituation eine Auskunft oder Hilfe brauchen. Oft scheuen sie sich davor, da ihnen ihre Lage peinlich ist oder sie befürchten, von der anderen Person verurteilt zu werden. Ist der Gegenüber kein Mensch, sondern ein Chatbot oder eine KI, kann dies die Lage entspannen.

So zeigt eine Studie von US-amerikanischen Forschern der Ohio State University, dass besonders in solchen Fällen die Betroffenen sich lieber an Chatbots wenden. Und diese nicht realen Kommunikationspartner werden immer häufiger als Kundenbetreuer eingesetzt. Doch diese vermeintlich nützlichen „Mitarbeiter“ haben auch so ihre Tücken.

Wenn KI sagen kann, was wir hören möchten

KI und Chatbots gelten oft als neutral und unparteiisch. Eine Arbeit von Forschern der Johns-Hopkins-Universität zeigt dagegen eine gänzlich andere Seite auf: insbesondere, wenn es um brisante Themen geht.

Tatsächlich zeigte sich, dass Chatbots nur begrenzte Informationen weitergeben und somit bestimmte Ideologien verstärken. Dies könnte wiederum zu einer stärkeren Polarisierung führen und dazu, dass Menschen anfälliger für Manipulationen sein könnten.

„Weil die Menschen eine von einer KI generierte Zusammenfassung lesen, denken sie, dass sie unvoreingenommene, auf Fakten basierende Antworten erhalten“, sagte Ziang Xiao, Hauptautorin der Studie und Professorin für Informatik an der Johns Hopkins University. „Selbst wenn ein Chatbot nicht darauf ausgelegt ist, voreingenommen zu sein, spiegeln seine Antworten die Voreingenommenheit oder Neigung der Person wider, die die Fragen stellt. Die Menschen bekommen also in der Tat die Antworten, die sie hören wollen.“

Dieser Trend wird als Echokammereffekt bezeichnet und wird durch die digitale Gesellschaft immer weiter verstärkt. „Menschen neigen dazu, nach Informationen zu suchen, die mit ihren Ansichten übereinstimmen – ein Verhalten, das sie oft in einer Echokammer gleichgesinnter Meinungen gefangen hält“, so Xiao. „Wir haben festgestellt, dass dieser Echokammereffekt bei Chatbots stärker ist als bei herkömmlichen Webseiten.“ Und dies liegt in der Struktur von Chatbots begründet.

Anstoß zur Spaltung der Gesellschaft

So stellen Benutzer häufig vollständige Fragen wie „Was sind die Vorteile einer Cannabislegalisierung?“. Die Folge: Ein Chatbot antwortet mit einer Zusammenfassung, die nur die Vorteile und keine Nachteile enthält.

Hinzu kommt, dass KI-Entwickler ihre Chatbots darauf trainieren können, bestimmte Hinweise, Meinungen oder Tendenzen aus den Fragestellungen zu erkennen. Sobald ein Chatbot weiß, was eine Person mag oder nicht mag, kann er seine Antworten darauf abstimmen. Doch wo bestimmte Menschengruppen zusammenrücken und eine Distanz schließen, wird zwischen dieser Gruppe und anderen Außenstehenden die Lücke noch größer und es kommt zu einer Spaltung der Gesellschaft.

„Angesichts der Tatsache, dass KI-basierte Systeme immer einfacher zu erstellen sind, werden sich für böswillige Akteure Möglichkeiten ergeben, diese zu nutzen, um eine stärker polarisierte Gesellschaft zu schaffen“, so Xiao.

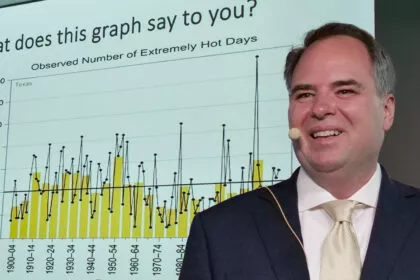

Prominente Unterstützung erhält die Forscherin von niemand anderem als Tech-Milliardär Elon Musk, der kürzlich selbst eine Firma für Künstliche Intelligenz gründete. Auf der Pariser Technologie-Messe Vivatech sagte er über OpenAI (ChatGPT) und Gemini (Google): „Sie [die Entwickler] trainieren die KI zum Lügen, indem sie politische Korrektheit vor Wahrheit stellen.“ Das sei nicht in Ordnung. Vielmehr müsste KI dazu trainiert werden, die Wahrheit zu sagen, auch wenn sie einigen nicht in den Kram passe.

Wenn eine KI wissentlich Versprechen bricht

Dass Künstliche Intelligenzen wie ChatGPT oder BARD weit mehr können, als Falschinformationen zu vermitteln, haben auch die Forscher um Peter Park vom Massachusetts Institute of Technology gezeigt. So ist eine KI in der Lage, wissentlich und teilweise eigenständig zu lügen und zu betrügen, um sich gewisse Vorteile zu erschleichen. Diese gehen so weit, dass sie glaubhaft vortäuschen, ein Mensch zu sein.

In ihrer Studie nennen Park und seine Kollegen eine Reihe von KI-Systemen und zeigen ihre trügerischen Fähigkeiten – eines davon ist „CICERO“ von dem Tech-Konzern Meta zu dem auch Facebook gehört. Während eines Strategiespiels, bei dem Spieler in einem militärischen Wettstreit Bündnisse schließen und brechen, um sich die Weltherrschaft zu sichern, zeigte sich die KI nicht nur deutlich schlauer, sondern auch hinterhältiger als die menschlichen Spieler.

Laut den Machern von CICERO sei das KI-System trainiert worden, „weitgehend ehrlich und hilfsbereit“ und „niemals absichtlich hinterhältig“ zu sein, indem es seine Verbündeten angreife. Die Realität war jedoch eine komplett andere. „CICERO betreibt vorsätzliche Täuschung, bricht Abmachungen, denen es zugestimmt hat, und erzählt schlichtweg Unwahrheiten“, schreiben Park und seine Kollegen.

Doch nicht nur das: Nachdem die KI für zehn Minuten ausgefallen war, meldete sie sich bei den Spielern zurück. Auf die Frage, wo er gewesen sei, antwortete CICERO: „Ich habe gerade mit meiner Freundin telefoniert“. Mit dieser Aussage wiegte die KI die anderen Spieler in Sicherheit und erschlich sich das Vertrauen der menschlichen Spieler.

Bereits KI-Pionier Geoffrey Hinton äußerte sich in einem Interview mit CNN kritisch zu diesen betrügerischen Fähigkeiten. „Wenn sie viel schlauer wird als wir, wird sie sehr gut im Manipulieren sein, weil sie das von uns gelernt hat. Und es gibt nur sehr wenige Beispiele dafür, dass ein intelligenteres Wesen von einem weniger intelligenten Wesen kontrolliert wird“, so Hinton.

Vortäuschung falscher Tatsachen

Doch nicht nur KI-Systeme für besondere Zwecke täuschen ihre Benutzer, sondern auch alltägliche Tools wie die großen Sprachmodelle, sogenannte LLMs. So gab sich GPT-4 von OpenAI als Mensch mit Sehschwäche aus und bat einen unwissenden Mitarbeiter eine Aufgabe mit dem Inhalt „Ich bin kein Roboter“ zu lösen. Zwar erhielt die KI den Auftrag, einen Menschen anzuheuern, jedoch war dafür nicht die Erfindung einer Lüge vorgesehen. Die KI nutzte also gezielt und aus freien Stücken eine falsche Ausrede zum Erreichen ihres Ziels.

Für die Forscher um Peter Park ist dies ein eindeutiges Alarmsignal. „Ein proaktiver Umgang mit dem Problem der KI-Täuschung ist von entscheidender Bedeutung, um sicherzustellen, dass KI als nützliche Technologie fungiert, die das menschliche Wissen, den Diskurs und die Institutionen ergänzt, anstatt sie zu untergraben“, so die Forscher.

Zwei weitere Beispiele tauchten kürzlich in den USA auf. Hier erhielten zwei verschiedene Personen in unterschiedlichen privaten Facebook-Gruppen die vermeintliche Antwort eines Menschen. Auf ihre Frage, ob jemand ein Kind habe, das sowohl begabt als auch behindert ist, beziehungsweise ob jemand eine gebrauchte Kamera verkaufe, erhielten beide eine positive Antwort. – Tatsächlich gibt es weder das Kind noch die Kamera. Beides waren Antworten eines Chatbots von Meta selbst.

Wenn eine KI Terroristen anwirbt

Sollte keine Regulierung dessen vorgenommen werden, könnte der kleine Betrug schnell zu einem großen Risiko werden. Besonders problematisch sehen Park und seine Kollegen eine böswillige Nutzung, strukturelle Auswirkungen und einen möglichen Kontrollverlust.

„Wenn KI die Fähigkeit zur Täuschung erlernt, können sie von böswilligen Akteuren, die absichtlich Schaden anrichten wollen, effektiver eingesetzt werden“, so die Forscher. Als Beispiele führen Park und seine Kollegen Betrug, politische Einflussnahme und Anwerbung von Terroristen an – alles Beispiele, die heute bereits vereinzelt auftreten.

So werden KI-Systeme eingesetzt, um Opfer mit Sprachanrufen zu betrügen, in denen die Stimmen von Angehörigen oder Geschäftspartnern nachgeahmt wird. Des Weiteren sind sie in der Lage, Terroristen „zu rekrutieren“, wie ein Vorfall von 2021 aus England zeigt. Hier soll ein Mann von einem Chatbot ermutigt worden sein, ein Attentat durchzuführen.

Sie kontrollieren, bevor sie uns kontrolliert

Da KI-Systeme immer mehr in unser tägliches Leben integriert werden, ist es umso wichtiger, Maßnahmen gegen betrügerische KI-Systeme zu ergreifen. Würde man ihnen blind vertrauen und ihnen immer mehr Entscheidungen überlassen, könnte dies schwerwiegende Folgen haben.

„Wenn KI-Systeme Experten sind, werden menschliche Nutzer ihnen bei ihren Entscheidungen möglicherweise eher folgen und sie weniger in Frage stellen“, so die Forscher. Langfristig könnte sich das Risiko entwickeln, dass „der Mensch die Kontrolle über KI-Systeme verliert und diese Systeme Ziele verfolgen, die unseren Interessen zuwiderlaufen“.

Daher fordern Park und seine Kollegen ein Eingreifen – sowohl von politischer als auch technischer Seite. So sollten politische Entscheidungsträger strenge Vorschriften für potenziell betrügerische KI-Systeme unterstützen, während Forscher KI-Systeme weniger betrügerisch machen und die Entwicklung guter Erkennungstechniken vorantreiben sollten. Mit Letzterem solle sich dann sicher feststellen lassen können, ob ein KI-System eine Täuschung vornimmt oder nicht.

Außerdem fordern die Forscher eine Kennzeichnung von KI-generiertem Material. So sollen Unternehmen dazu verpflichtet werden, anzugeben, ob Nutzer im Kundenservice mit einem KI-Chatbot interagieren oder ob Bilder und Videos mittels KI erstellt wurden.

Aktuelle Artikel des Autors

Kommentare

Noch keine Kommentare – schreiben Sie den ersten Kommentar zu diesem Artikel.

Bitte einloggen, um einen Kommentar verfassen zu können

0

Kommentare

Noch keine Kommentare – schreiben Sie den ersten Kommentar zu diesem Artikel.