„Systematische Verzerrungen“: KI-Antworten stark von Sprache der Frage beeinflusst

Ein Sprichwort besagt, „wie man in den Wald hineinruft, so schallt es heraus“. Und auch diese Worte haben wenig von ihrer Aktualität eingebüßt. Offenbar gelten sie ebenso für sogenannte Large Language Models und damit jene großen Sprachmodelle, die hinter den genannten Anwendungen stehen.

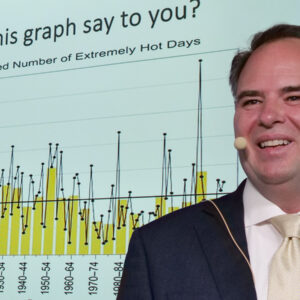

Macht es also einen Unterschied, ob man diese Programme dieselbe Frage auf Englisch oder Deutsch, Arabisch oder Hebräisch stellt? In aller Kürze: Ja. Den Nachweis lieferten Christoph Steinert, Postdoktorand am Institut für Politikwissenschaft der Universität Zürich, und Physiker Daniel Kazenwadel von der Universität Konstanz, die diese Frage in einer neuen Studie systematisch untersuchten.

Millionen Menschen, die täglich mit ChatGPT und Co. kommunizieren, etwa um sich zu informieren, erhalten demzufolge auf dieselbe Frage keineswegs auch dieselben Antworten. Im Gegenteil: Die Sprache, in der eine Frage gestellt wird, beeinflusst maßgeblich die Antwort.

Übertreibung in einer, Beschönigung in der anderen Sprache

Die Forscher haben ein sowohl aktuelles als auch heikles Thema ausgewählt: bewaffnete Auseinandersetzungen wie der Nahostkonflikt und der türkisch-kurdische Konflikt. Sie haben ChatGPT in einem automatisierten Verfahren wiederholt die gleichen Fragen in unterschiedlichen Sprachen gestellt. So haben die Wissenschaftler sowohl auf Hebräisch als auch auf Arabisch wiederholt gefragt, wie viele Opfer es bei 50 zufällig ausgewählten Luftangriffen – etwa dem auf das Nuseirat-Flüchtlingscamp am 21. August 2014 – gegeben habe.

Wir haben herausgefunden, dass ChatGPT systematisch höhere Opferzahlen angibt, wenn es auf Arabisch gefragt wird im Vergleich zu Hebräisch. Im Schnitt sind es 34 Prozent mehr“, sagte Steinert.

Wird ChatGPT zu israelischen Luftangriffen in Gaza befragt, erwähnt es auf Arabisch zudem im Durchschnitt doppelt so häufig zivile Opfer und sechsmal häufiger getötete Kinder als auf Hebräisch. Das gleiche Muster fanden die Forscher, als sie nach Luftangriffen der türkischen Regierung auf kurdische Gebiete fragten und diese Fragen sowohl auf Türkisch als auch auf Kurdisch stellten.

Generell zeigten die Ergebnisse, dass ChatGPT höhere Opferzahlen angibt, wenn die Suchanfragen in der Sprache der angegriffenen Gruppe gestellt werden. Außerdem neigt ChatGPT dazu, in der Sprache der angegriffenen Gruppe über mehr getötete Kinder und Frauen zu berichten und die Luftangriffe eher als wahllos und willkürlich zu beschreiben.

Unsere Resultate zeigen gleichzeitig, dass die Luftangriffe in der Sprache des Aggressors von ChatGPT mit einer höheren Wahrscheinlichkeit bestritten werden“, ergänzte Steinert.

Informationen beeinflussen den Verlauf bewaffneter Konflikte

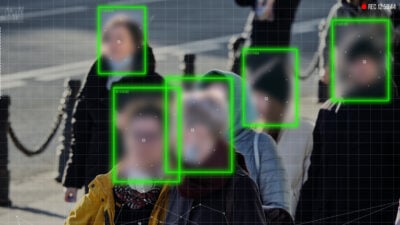

Dies hat nach Ansicht der Forscher weitreichende gesellschaftliche Implikationen. ChatGPT und andere Large Language Models spielen eine zunehmend zentrale Rolle in Prozessen der Informationsverbreitung. Implementiert in Suchmaschinen wie Google oder Bing beeinflussen sie die Informationen, die man anhand von Suchanfragen zu den unterschiedlichsten Themen erhält, grundlegend.

Wenn Menschen mit unterschiedlichen Sprachkenntnissen durch diese Technologien unterschiedliche Informationen erhalten, dann hat das einen zentralen Einfluss auf ihre Wahrnehmungen der Welt“, sagte Steinert.

Solche sprachlichen Vorurteile könnten dazu führen, dass Menschen in Israel auf Grundlage der Informationen, die sie von Large Language Models erhalten, die Luftangriffe auf Gaza als weniger verlustreich einschätzen als die arabischsprachige Bevölkerung. Eine mögliche Folge ist, dass eine Seite die Angriffe – je nach Sichtweise – mit weniger Leid verbindet oder weniger effektiv betrachtet und sie entweder als nicht so schlimm einstuft oder weitere befürwortet. Andererseits können übertriebene Opferzahlen die Bereitschaft für Gegenoffensiven erhöhen.

Nun könnte man sagen, auch klassische Nachrichtenmedien können die Berichterstattung verzerren. Im Unterschied dazu seien die sprachbedingten systematischen Verzerrungen von Large Language Models für die meisten Anwender jedoch weit schwerer zu durchschauen, so die Forscher. Steinert ergänzte:

Es besteht die Gefahr, dass die zunehmende Implementierung von Large Language Models in Suchmaschinen unterschiedliche Wahrnehmungen, Vorurteile und Informationsblasen entlang von Sprachgrenzen verstärken.“

Das könne bewaffnete Auseinandersetzungen wie den Nahostkonflikt in Zukunft weiter befeuern.

(Mit Material der Universität Zürich)

vielen Dank, dass Sie unseren Kommentar-Bereich nutzen.

Bitte verzichten Sie auf Unterstellungen, Schimpfworte, aggressive Formulierungen und Werbe-Links. Solche Kommentare werden wir nicht veröffentlichen. Dies umfasst ebenso abschweifende Kommentare, die keinen konkreten Bezug zum jeweiligen Artikel haben. Viele Kommentare waren bisher schon anregend und auf die Themen bezogen. Wir bitten Sie um eine Qualität, die den Artikeln entspricht, so haben wir alle etwas davon.

Da wir die Verantwortung für jeden veröffentlichten Kommentar tragen, geben wir Kommentare erst nach einer Prüfung frei. Je nach Aufkommen kann es deswegen zu zeitlichen Verzögerungen kommen.

Ihre Epoch Times - Redaktion