Planlos und verwirrt: Baustellen bringen KI an ihre Grenzen

„Das Wirkliche ist beschränkt, das Mögliche grenzenlos.“ Als der französische Epiker Alphonse de Lamartine dies um 1820 sagte, ahnte er kaum, dass es zwei Jahrhunderte später Künstliche Intelligenz gibt, die keine Grenzen zu haben scheint. Doch in Wirklichkeit ist auch die KI in ihrem Können beschränkt, wie Forscher des Massachusetts Institute of Technology (MIT) herausfanden.

Während große Sprachmodelle wie ChatGPT, Gemini und Llama erstaunlich kreativ im Schreiben von Gedichten sind, hapert es zuweilen an der Improvisation. So fanden Ashesh Rambachan und seine Kollegen heraus, dass eine beliebte KI mit nahezu perfekter Genauigkeit Abbiegehinweise in New York City geben kann, ohne jemals eine genaue Karte der Stadt erstellt zu haben.

Dennoch könnten sich Autofahrer trotz des KI-Navis und weit mehr als einmal fragen: „Wo bin ich?“ Denn die Navigationsleistung brach augenblicklich ein, als die MIT-Forscher einige Straßen sperrten und Umleitungen nötig wurden.

Fantasiestraßen und verborgene Abkürzungen

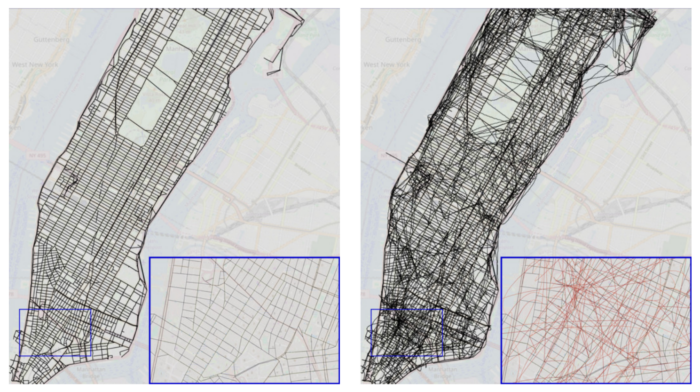

Welche Informationen und Quellen der vom KI-Modell implizierten Karte zugrunde liegen, ist derweil nicht immer klar. Bei näherer Betrachtung im Fall der New Yorker Straßen stellten die Forscher jedoch fest, dass sich die KI viele nicht existierende Straßen vorstellte. Wie aus dem Nichts auftauchend und keinem realen Weg folgend verbinden diese Scheinstraßen weit entfernte Kreuzungen miteinander – ein Szenario, das Fans von Mario Kart bekannt vorkommen könnte.

Im echten Leben könnte dies aber schwerwiegende Folgen für Mensch und Technik haben. So können Fahrer nicht nur in die Irre geführt und Gefahren ausgesetzt werden, sondern auch das Modell, das in einem bestimmten Kontext gut zu funktionieren scheint, zusammenbrechen lassen, wenn sich die Aufgabe oder die Umgebung leicht ändert.

„Eine Hoffnung ist, dass wir diese KI-Werkzeuge vielleicht auch in anderen Bereichen der Wissenschaft einsetzen können. Aber die Frage, ob große Sprachmodelle kohärente Weltmodelle lernen, ist sehr wichtig, wenn wir diese Techniken nutzen wollen, um neue Entdeckungen zu machen“, sagte Ashesh Rambachan, Assistenzprofessor für Wirtschaftswissenschaften am MIT.

Wackeliges Rückgrat der KI

In ihrer Forschung konzentrierten sich die MIT-Techniker auf eine Art generatives KI-Modell, den sogenannten Transformator. Dieser bildet standardgemäß das Rückgrat der sogenannten Großen Sprachmodelle wie GPT-4. Transformatoren werden auf einer riesigen Menge von sprachbasierten Daten trainiert, um das nächste Element in einer Sequenz vorherzusagen, etwa das nächste Wort in einem Satz.

Die Fähigkeit der Vorhersage allein ist jedoch kein Beweis für ein umfassendes Verständnis. Zum Beispiel könne ein Transformator fast jedes Mal gültige Züge in einem Computerspiel vorhersagen, ohne die Regeln zu verstehen. Mit anderen Worten, von den Ergebnissen lässt sich nicht auf die Genauigkeit schließen.

Daher entwickelte das Team zwei neue Metriken, um das Weltmodell eines Transformators zu testen. Die Forscher konzentrierten sich bei ihren Bewertungen auf eine Klasse von Problemen, die als „deterministische endliche Automaten“ bezeichnet werden. Dabei handelt es sich um ein Problem mit einer Abfolge von Zuständen, zum Beispiel das Überqueren von Kreuzungen, um an ein Ziel zu gelangen, während man sich an exakt beschriebene Regeln zu halten hat, einschließlich so banal erscheinender, dass man nicht durch Gebäude gehen kann.

Getestet haben die Forscher dies anhand von zwei Beispielen: der Navigation durch die Straßen von New York City und des Spielens des Brettspiels „Othello“. „Wir brauchten Testumgebungen, bei denen wir wissen, wie das Weltmodell aussieht“, erklärt Keyon Vafa, Doktorand an der Harvard-Universität und Kollege von Rambachan.

Zusammenhanglose Weltmodelle

Überraschenderweise stellten die Forscher fest, dass Transformatoren, die ihre Entscheidungen nach dem Zufallsprinzip trafen, im weiteren Verlauf genauere Weltmodelle bildeten. Dies könnte daran liegen, dass sie während des Trainings eine größere Vielfalt an möglichen nächsten Schritten erkannten.

„Wenn man bei Othello zwei zufällige Gegner spielen sieht und nicht die Spieler der Meisterschaft, sieht man theoretisch alle möglichen Züge, sogar die schlechten, die die Spieler der Meisterschaft nicht machen würden“, erklärt Vafa.

Ein Pluspunkt war, dass die Transformatoren in fast allen Fällen korrekte Wege und gültige Spielzüge erzeugten. Schlechter sah es jedoch in Bezug auf das Weltmodell aus. Beim Brettspiel konnte die KI in einem der beiden Fälle ein stimmiges Weltmodell erzeugen, während beim Routenplanen keines gut abschnitt. Noch chaotischer wird es, wenn Unvorhergesehenes wie das Hinzufügen von Baustellen in New York City auftritt.

„Ich war überrascht, wie schnell sich die Leistung verschlechterte, sobald wir eine Umleitung hinzufügten. Wenn wir nur 1 Prozent der möglichen Straßen sperren, sinkt die Genauigkeit sofort von fast 100 Prozent auf nur 67 Prozent“, sagt Vafa.

Als sie die von den Modellen erstellten Stadtpläne wiederherstellten, sahen sie aus wie ein imaginäres New York City mit Hunderten Straßen, die kreuz und quer verlaufen. Die Karten enthielten oft zufällige Überführungen über andere Straßen oder mehrere Straßen mit unmöglichen Ausrichtungen.

Straßenkarte von Manhattan (l.) und eine der vielen Varianten, wie sich KI das Straßennetz vorstellt (r.). Zahllose imaginäre Straßen und Brücken (im Kartenausschnitt rot über den „echten“ in schwarz) führen zu unmöglichen Routenanweisungen und leiten in die Irre. Foto: Vafa et al. (2024), Zuschnitt: ts/Epoch Times

KI durch Zufall gut

Diese Ergebnisse zeigen, dass Transformatoren bei bestimmten Aufgaben erstaunlich gut abschneiden können, ohne die Regeln zu verstehen. Wenn große Sprachmodelle künftig recht genaue Weltmodelle besitzen sollen, müssten ihre Entwickler jedoch einen anderen Ansatz wählen, so die Forscher.

„Oft sehen wir, dass diese Modelle beeindruckende Dinge tun. Wir denken dann, dass sie etwas von der Welt verstanden haben müssen. Ich hoffe, dass wir die Leute davon überzeugen können, dass man darüber sehr sorgfältig nachdenken muss und wir uns mitunter auf unsere eigene Intuition verlassen müssen“, sagte Rambachan.

Künftig wollen die Forscher weitere Probleme untersuchen, bei denen etwa Regeln nur teilweise bekannt sind. Außerdem wollen sie ihre Bewertungsmaßstäbe auf reale wissenschaftliche Probleme anwenden.

Die Studie erschien vorab online am 10. November 2024 auf „arXiv“.

vielen Dank, dass Sie unseren Kommentar-Bereich nutzen.

Bitte verzichten Sie auf Unterstellungen, Schimpfworte, aggressive Formulierungen und Werbe-Links. Solche Kommentare werden wir nicht veröffentlichen. Dies umfasst ebenso abschweifende Kommentare, die keinen konkreten Bezug zum jeweiligen Artikel haben. Viele Kommentare waren bisher schon anregend und auf die Themen bezogen. Wir bitten Sie um eine Qualität, die den Artikeln entspricht, so haben wir alle etwas davon.

Da wir die Verantwortung für jeden veröffentlichten Kommentar tragen, geben wir Kommentare erst nach einer Prüfung frei. Je nach Aufkommen kann es deswegen zu zeitlichen Verzögerungen kommen.

Ihre Epoch Times - Redaktion