Fotos verzerren Geschichte: KI-„historische“ Fotos rauschen durchs Internet

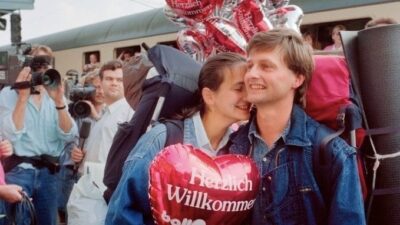

Auf den ersten Blick scheinen sie reale historische Momente einzufangen, aber sie sind mit Künstlicher Intelligenz (KI) erstellt. Nutzer teilen solche vermeintlich historischen Fotos massenhaft im Internet. Die meist in Schwarzweiß gehaltenen Bilder bergen nach Ansicht von Fachleuten die Gefahr, die Geschichte zu verzerren.

Auf Facebook kursierte beispielsweise ein Bild, das die Gebrüder Wright, zwei Pioniere der Luftfahrt, nach ihrem ersten Motorflug im Jahr 1903 zeigen soll. Man sieht ein lächelndes Brüderpaar mit blonden Haaren vor einem Flugzeug posieren.

Dagegen sind auf echten Archivfotos zwei Männer mit Schiebermützen zu sehen, die dem blonden Paar nicht ähneln. Auch die Atmosphäre der Fotografien ist ganz anders. Auf den Originalfotos werden sind sie entweder mit ernsten Mienen abgebildet oder bloß als ferne Silhouetten zu sehen, die am Prototyp ihres Flugzeugs arbeiten.

Gefälschte Fotos verzerren Geschichte

Warum wurde dieses gefälschte Foto produziert? Eine Anfrage der Nachrichtenagentur AFP ließ der Urheber der Fälschung unbeantwortet. Allerdings verriet das Bild, welcher Prompt – also welche Anweisung – von ihm in das KI-Programm eingegeben wurde. Demnach sollte eine „feierliche“ Atmosphäre geschaffen werden.

„KI hat einen Tsunami gefälschter Geschichte verursacht, insbesondere im Bereich der Bilder“, beklagt die niederländische Historikerin Jo Hedwig Teeuwissen. In Online-Netzwerken spürt sie unter dem Pseudonym „Fake History Hunter“ falsche Behauptungen oder Vorurteile über geschichtliche Entwicklungen auf.

„In manchen Fällen handelt es sich um KI-Reproduktionen tatsächlich existierender Archivfotos. Das ist wirklich seltsam, besonders wenn die Originale sehr bekannt sind“, wundert sich die Wissenschaftlerin.

KI-Bilder zur Hiroshima-Atombombe

So wurden mit dem beliebten KI-Bildprogramm Midjourney Fälschungen erstellt, die berühmte Fotografien nachahmen – etwa die Tötung von Lee Harvey Oswald, dem mutmaßlichen Mörder von John F. Kennedy, im Jahr 1963.

Es gibt auch Midjourney-Bilder, die angeblich die Explosion der Hiroshima-Atombombe am 6. August 1945, den Einmarsch von Truppen des Warschauer Pakts in Prag im August 1968 oder das Kolosseum im antiken Rom zeigen – sie alle sind nicht echt.

Den Trend dieser durch KI generierten falschen Archivfotos kritisiert auch Marina Amaral. Die Brasilianerin ist Künstlerin und hat sich auf die Kolorierung alter Fotos spezialisiert. Die Inszenierung von „Ereignissen, die zu lange her sind, um fotografiert werden zu können“ oder Momenten in der Geschichte, die „schlecht dokumentiert“ sind, bereiten ihr Sorgen.

„Das Risiko besteht darin, dass diese falschen Bilder als historische Fakten angesehen werden und dass das im Laufe der Zeit unser Verständnis der Geschichte verändern und das Vertrauen der Öffentlichkeit in (das Bild) als verlässliche Quelle für das Studium der Vergangenheit schwächen wird“, glaubt Amaral.

Wie kann das Echte vom Falschen unterschieden werden?

Noch sind Marina Amaral und Jo Hedwig Teeuwissen überzeugt, dass sie dank ihres Fachwissens und bestimmter Fehler in der Lage sind, das Echte vom Gefälschten zu unterscheiden.

KI-generierte Fotos weisen ihren Erkenntnissen zufolge oft noch verräterische Fehler auf: zu viele Finger an einer Hand, nicht vorhandene Details – wie das Fehlen eines Propellers am Flugzeug der Gebrüder Wright – oder andersherum: einen zu perfekten Bildaufbau.

Gewisse Eigenschaften echter Fotografien könne die KI nicht nachahmen, etwa bei Schnappschüssen eines Augenblicks voller Emotionen, urteilt Amaral. „Ihnen fehlt das menschliche Element, die Absicht, der Grund für die Entscheidungen des Fotografen. Obwohl sie visuell überzeugend sind, bleiben diese Bilder hohl“, findet die Künstlerin.

Für Teeuwissen werden „echte Fotos von echten Menschen gemacht und normalerweise ist etwas unscharf, oder jemand sieht aus Versehen albern aus, das Make-up sieht schlecht aus und so weiter“.

Die Historikerin schätzt jedoch, dass es „nur eine Frage der Zeit“ ist, bis die Qualität der KI-Bilder Fälschungen mit bloßem Auge schwer erkennbar macht. Das sei eine „gefährliche“ Aussicht, welche die Macht der Desinformation zu stärken drohe. (afp/red)

vielen Dank, dass Sie unseren Kommentar-Bereich nutzen.

Bitte verzichten Sie auf Unterstellungen, Schimpfworte, aggressive Formulierungen und Werbe-Links. Solche Kommentare werden wir nicht veröffentlichen. Dies umfasst ebenso abschweifende Kommentare, die keinen konkreten Bezug zum jeweiligen Artikel haben. Viele Kommentare waren bisher schon anregend und auf die Themen bezogen. Wir bitten Sie um eine Qualität, die den Artikeln entspricht, so haben wir alle etwas davon.

Da wir die Verantwortung für jeden veröffentlichten Kommentar tragen, geben wir Kommentare erst nach einer Prüfung frei. Je nach Aufkommen kann es deswegen zu zeitlichen Verzögerungen kommen.

Ihre Epoch Times - Redaktion